现如今,“百模大战”已经成为中国面向AIGC大模型竞争激烈最外在的体现。与此同时,面对生成式AI开发与应用场景,如何提供从集群系统环境部署到算力调度保障和大模型开发管理的全栈全流程,降低大模型算力系统的使用门槛、优化大模型的研发效率,保障大模型的生产与应用的诸多挑战和障碍也浮出水面,而何以应对将直接关系着大模型应用及未来的进一步发展。

政策与趋势双重利好,AIGC呈现“百模大战”之势

提及AIGC大模型,从2020年 GPT-3发布以来,OpenAI等国内外的科技企业和研究机构通过零样本学习(Zero-Shot Learning)、提示词工程(Prompt Engineering)、指令微调(SFT)、人类反馈强化学习(RLHF)等诸多技术创新,找到了有效使用大模型的技术范式。而2022年底发布的ChatGPT更是成功引爆了公众对于生成式人工智能的热情。

进入到今年,国内外针对生成式AI的投资激增,微软、谷歌等众多科技公司都在开发生成式AI模型。截止到2023年7月,仅国内发布的生成式AI模型已经超过了100个,呈现出“百模大战”之势。

究其原因,从政策层面,2023年4月28日,中央政治局召开会议,指出要重视通用人工智能发展,营造创新生态,重视防范风险。而为贯彻落实国家相关决策部署,《若干措施》提出,要“系统构建大模型人工智能技术体系”、“推动通用人工智能技术创新场景应用”。《行动方案》也强调,要打造全域全时场景应用,推进“千行百业+AI”,孵化高度智能化的生产机器人;通过大力推进通用人工智能和政务服务、医疗、金融等各个领域的融合发展,有效实现数据、算力、算法计算机行业点评的复用,大大拓展大模型的价值边界。

除上述国家相关政策外,《北京市促进通用人工智能创新发展的若干措施》、《上海市促进人工智能产业发展条例》《上海市加大力度支持民间投资发展若干政策措施》以及《深圳市加快推动人工智能高质量发展高水平应用行动方案(2023-2024年)》等相关政策也相继出台和实施。

由此不难看出,从国家到地方,关注通用人工智能的系统建设,探索通用人工智能新路径,推动创新场景应用已经成为业内的思想共识、政策共识和发展共识。

另一方面,大模型的开源开放进一步激发了学界和社区的热情。例如META在2023年3月开源的LLaMA(羊驼)大模型在短短的几个月时间内就演化出了蓬勃发展的一个大模型社区,基于LLaMA进行衍生开发的大模型包括Alpaca、BELLE、Vicuna、 Koala、Orca等。

此外,Falcon、MPT等众多模型的开源进一步丰富了社区生态,促进了业界对AIGC的应用落地探索。当前,基于大模型技术的创新应用已经开始广泛地进入到日常生活和办公之中,这些系统包括大型语言模型聊天机器人,如ChatGPT和Bard;办公助手MS office copilot、笔记AI助手notion AI和编程助手GITHUB copilot等。

智算成驱动AIGC发展核心引擎,系统性挑战显现

面对上述政策与趋势带来的利好,智算是驱动AIGC发展核心引擎自然也成为业内的共识,但随之而来的则是算力瓶颈、数据瓶颈和算法瓶颈的出现,并直接影响到了业内大模型的开发、构建及应用效率。

据统计,以ChatGPT的总算力消耗3640PFdays计算,需要7—8个投资规模30亿、算力500P的数据中心支撑运行。尽管如此巨大的投入,GPT3的集群训练效率仅为23%。虽然硬件改进可以降低FLOPs成本,但大模型的持续升级,使得算力的总成本一直在增加。相比之下,同为大模型的源1.0的算力效率则达到45%,名列前茅。

那么业内不禁要问,造成上述瓶颈,并导致最终实际应用效率迥异的原因是什么?

对此,浪潮信息高级副总裁刘军认为,“通过源1.0这样千亿级别大模型的工程实践,我们成为了业内少有的既是算力基础设施(懂算力),同时又懂大模型的厂商。而现实是,有好多做算力基础设施的不懂模型,做模型的又不懂服务器、算力和系统,这个时候,二者兼具的优势就在实践中体现出来了”。

其实在我们看来,刘军解释的背后从另一个角度反映的是当下面向AIGC的大模型发展中造成瓶颈,并导致最终实际应用效率迥异的系统性挑战的显现。

具体表现为,面向AIGC大模型的构建、开发和应用,算力平台的构建已不仅仅是服务器、存储、网络等硬件设备的集成,也有诸多设备软硬件兼容性和性能调教上的know-how。需要考虑不同硬件和软件之间的兼容性和版本选择,确保驱动和工具的适配性和稳定性。

例如在InfiniBand、RoCE网络的配置和驱动安装上会遇到一些复杂的网络设置和驱动安装问题。由于涉及到用户管理,GPU运行基础环境,并行文件系统等多个组件的安装和配置,往往需要依赖丰富的经验,整个部署过程会比较复杂,例如在实际的生产环境中,安装和配置集群需要兼顾性能和稳定性的考虑,为了确保系统的高性能和稳定运行,需要验证在不同的硬件环境下的软件适配,优化包括BIOS,操作系统,底层驱动,文件系统和网络等多个指标,找到最优的选择这个过程耗时耗力,容易贻误算力的上线时间。

这里需要补充说明的是,大模型训练过程比传统的分布式训练复杂,训练周期长达数月。集群计算效力低、故障频发且处理复杂,会导致训练中断后不能及时恢复,从而会降低大模型训练的成功概率,也会使得大模型训练成本居高不下。

在大模型的算法开发层面,从PB级数据的爬取、清洗、过滤和质检,到大规模预训练的算法设计、性能优化和失效管理;从指令微调数据集的设计到人类反馈强化学习训练的优化,冗长的开发链条意味着需要诸多工程化工具的支撑。

在大模型的部署与应用层面,在当前商业模型与开源模型能力表现各有专长的现状下,如何选择最为合适的基础模型,以及如何基于基础模型和行业特点,打造应用,实现大模型的落地依然是当前大模型在部署和应用上的最大挑战。

综上,在我们看来,业内亟需从系统层面为未来大模型的良好生态发展寻找最优解,即通过构建高效稳定的智算系统,深耕发掘系统部署、集群优化,资源调度,数据处理、训练加速、算法优化等全面的能力,让炼大模型更省时、省力,让大模型更快、更稳、更智能。

对症下药,OGAI呼之已出的逻辑

所谓对症下药。为了应对大模型发展中,呈现出的算力平台、算法开发及部署和应用层面的挑战,作为AI基础设施系统级厂商的浪潮信息日前正式发布了“大模型智算软件栈OGAI”。

那么问题来了,浪潮信息发布大模型智算软件栈OGAI的技术逻辑是什么?

对此,浪潮信息人工智能与高性能应用软件部AI架构师Owen ZHU解释称,“原来客户买一个服务器就可以直接使用,但随着AIGC对于算力需求的持续增加,部署的服务器越来越多,甚至要构建和使用集群,这导致算力基础设施已经像一部性能强大的法拉力跑车面向普通驾驶者难以驾驭一样,光把硬件设备买回去已经不足以满足他们做大模型的需求,而OGAI的目的和出发点则是在提供硬件(例如服务器、集群构建等)的基础上,进一步帮助他们去解决自身做大模型构建和应用可能遇到的问题,是针对每一层提炼了我们看到的与AIGC大模型相关的作业环境里面的关键问题,并通过自身以及我们服务客户的实践,提供软件以及对应的方案帮助客户构建、开发和应用大模型效率的提升”。

事实真的如此吗?

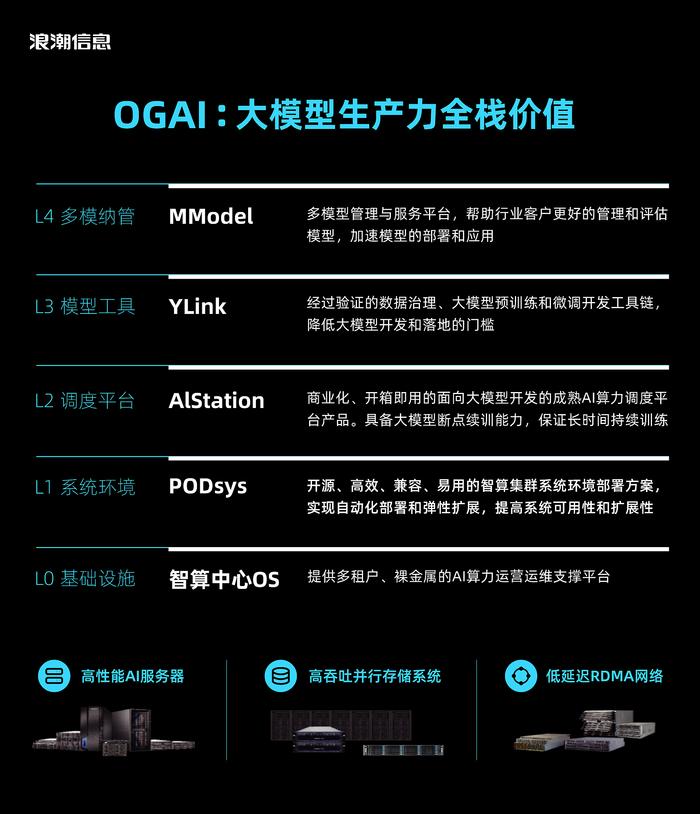

纵观该软件栈,其由5层架构组成,从L0到L4分别对应于基础设施层的智算中心OS产品、系统环境层的PODsys产品、调度平台层的AIStation产品、模型工具层的YLink产品和多模纳管层的MModel产品。

其中L0层智算中心OS面向智算中心等公共算力服务平台,面向多租户场景,提供灵活多样的裸金属AI算力服务;L1层PODsys聚焦智算集群部署场景,提供了包括基础设施环境安装、环境部署、用户管理、系统监控和资源调度一整套工具链,提供易用、高效、开放、兼容的智算集群系统环境部署方案;L2层AIStation面向AI开发场景, 通过云原生技术对集群系统中的计算资源、存储资源和网络资源进行统一的接入和纳管,提供了易于使用的开发环境和作业管理界面,并基于内置算力调度系统和训练稳定保障系统来实现易于接入、按需分配、弹性扩展和和高效稳定的AI研发应用支撑平台;L3层YLink针对大模型的开发过程,通过集成整合浪潮信息在大模型研发过程中的工具和开源工具,为用户提供高效、便捷与标准化的大模型开发与优化流程;L4层MModel定位于多模型管理与服务平台,帮助客户更好的管理和评估模型,加速模型的部署和应用。

从上述OGAI的构成,相信业内很容易发现,OGAI是提供从集群环境搭建到算力调度,再至大模型开发的全栈软件,并覆盖了大模型从数据处理、预训练和模型微调工具到多模型管理的整个研发流程工具链。而为了满足大模型计算对算力的需求,OGAI在不同的层次强调了性能优化,从服务器BIOS的调教到大规模集群组网性能和算力调度策略的多尺度、多层次的性能优化,来充分释放智算集群性能。另外,OGAI也融合了浪潮信息此前在MLPerf性能评测、服务客户实际需求、源大模型开发中的最佳实践。需要说明的是,OGAI采用的是分层解耦设计,这意味着用户可以根据自身的需要各取所需。

最后,值得一提的是,OGAI不仅是一款智算软件栈。未来,基于浪潮信息元脑生态平台,通过聚合元脑生态力量,将各类通用模型、行业模型、工具和技术能力进行整合,共同推动大模型技术在千行百业的落地和应用。

“助百模,智千行”,是指“百模”领先的科技公司都希望把自己领先的模型能力能够落地到我们的企业和行业用户及应用场景中。我们要给它设计如何实现的适合的商业通道,就是浪潮信息的元脑生态。在这个生态中,大模型和AI科技公司是左手伙伴,还有连接最终行业、企业客户的右手伙伴,即系统集成商、软件开发商等。而浪潮信息把这两类伙伴聚集在元脑生态中,彼此携手,就可以实现一个N×M的效应,让模型伙伴领先的能力快速落地。刘军进一步解释了业内关心的OGAI未来助力AIGC产业化落地的路径。

写在最后:中国有句俗话:饭不是最后一口才吃饱的。纵观当下的“百模大战”,虽是百花齐放,但也不乏好高骛远者,例如有些企业推出了集训练和推理于一身的所谓大模型一体机,而从实际情况看,如何做好基础大模型的预训练、基于开源和第三方大模型的微调、针对自身需求大模型的正确选择才是目前客户面临的最大挑战和痛点,而能否很好解决这些挑战和痛点,决定着推理的效率乃至最终商业化落地的进程和效率。

从这个角度看,我们认为OGAI的推出可谓适逢其时,是直击目前面向AIGC大模型用户痛点的清障之举。而惟有如此,“助百模,智千行”才真正可期。

4000520066 欢迎批评指正

All Rights Reserved 新浪公司 版权所有