整理 | 华卫、核子可乐

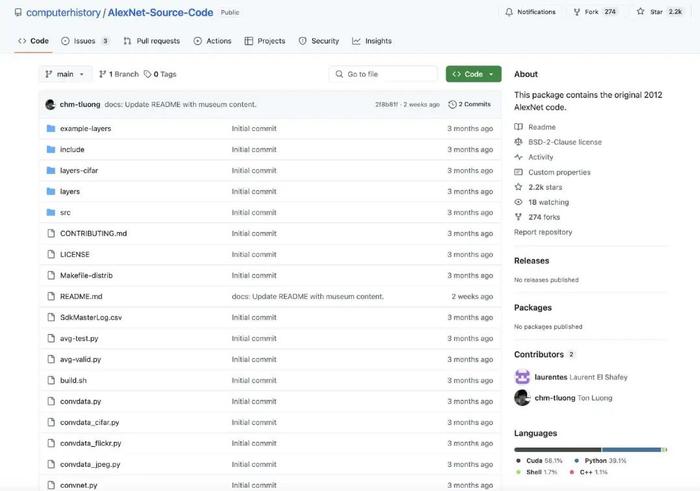

近日,谷歌与计算机历史博物馆(CHM)联合发布了 AlexNet 项目源代码。目前,项目的 Python 代码已作为开源软件在 CHM 的 GitHub 页面上对外开放,允许 AI 爱好者和研究人员一窥这项在计算发展史上开天辟地的关键成果。

AlexNet 是一种卷积神经网络 (CNN),其在 2012 年时被公认改变了 AI 领域的面貌,表明“深度学习”可以实现传统 AI 技术所无法达成的诸多功能。

GitHub 链接:https://github.com/computerhistory/AlexNet-Source-Code

深度学习技术采用多层神经网络,无需明确编程即可从数据中学习,由此开辟了一条与依赖手工制定规则与特征制定的传统 AI 截然不同的实现路径。深度学习推动了医疗保健、科学研究和无障碍工具的进步,但它也促进了深度伪造、自动监控以及广泛失业的可能性等发展。但在 2012 年,这些负面后果对于当时的人们来说还只是个遥不可及的科幻梦想。专家只是惊讶于计算机终于能够以接近人类的准确度识别图像内容。

作为 AI 发展的一个分水岭,AlexNet 能够以前所未有的准确度识别出照片中的物体——具体来讲,它能正确将图像归入 1000 个类别中的具体一个,如“草莓”、“校车”乃至“金毛犬”,且错误率远远低于以往的 AI 系统。

如同观察最初 ENIAC 计算机的电路设计或者 Babbage 差分机一样,AlexNet 的源代码将让未来的历史学家们了解一项相对简单的实现方案是如何激发出重塑整个世界的 AI 技术的。

AlexNet 原始真实代码得以公开

正如 CHm 在其博文中所介绍,AlexNet 源自多伦多大学研究生 Alex Krizhevsky 和 Ilya Sutskever 及其导师 Geoffrey Hinton 的工作。该项目证明,深度学习技术确实胜过了传统计算机视觉方法。

神经网络凭借远超以往任何方法的质量识别出照片中的物体,并最终赢得 2012 年的 ImageNet 竞赛。当时正在意大利佛罗伦萨聆听相关演讲的计算机视觉资深专家 Yann LeCun 立即意识到它对 AI 领域的重要意义,据报道他在演讲结束后站起身来,称 AlexNet 是“计算机视觉历史上的一个明确转折点”。更具体地讲,AlexNet 的出现标志着定义现代 AI 的三大关键技术由此开始融合。

计算机历史博物馆的软件历史学家 Hansen Hsu 为发布具有历史意义的 AlexNet 源代码,与谷歌展开了长达五年的谈判。这一进程始于 2020 年,当时 Hsu 联系了 AlexNet 共同开发者 Alex Krizhevsky,希望获得代码发布授权。但由于谷歌早在 2013 年已收购该团队所属的 DNNresearch 公司,相关知识产权归属谷歌,初次接触未能达成共识。

转机出现在 Krizhevsky 将 Hsu 引荐给谷歌深度学习专家 Geoffrey Hinton 后。作为当年研发团队的核心成员,Hinton 主动协调博物馆与谷歌相关部门建立正式沟通渠道。在随后五年间,双方团队不仅需要解决复杂的法律授权问题,还需从众多迭代版本中精准识别 2012 年原始代码——这成为项目推进的关键难点。正如 Hsu 强调,尽管网络上存在大量以"AlexNet"命名的重构版本,但真正引发人工智能革命的原始实现始终未被公开,GitHub 上很多同名代码库都是基于这篇著名论文的重新创作。

通过比对论文细节与代码架构特征,双方最终确认了包含 2012 年 ImageNet 大赛突破性成果的初始版本。该版本因其完整保留了原始硬件适配方案和早期神经网络设计范式,被认定为最具历史价值的技术遗产。

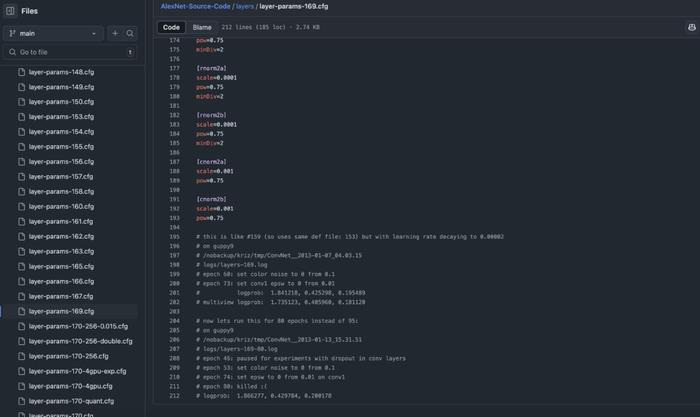

另外,除了代码本身的价值,HuggingFace 联合创始人 Thomas Wolf 还发现,代码中的注释也非常有启发性。

他说:“也许真正的历史在于 AlexNet 代码中,每个实验配置文件末尾的日志评论。”很多网友也同意他的看法。

背后的技术创新

虽然 AlexNet 对 AI 的影响如今已经成为传奇,但了解其背后的技术创新仍有助于解释它为何能够代表这个关键性的里程碑。具体来讲,这一突破并非单一技术革命的结果,而是先前单独开发的多项现有技术的优雅组合。

该项目融合了之前相互独立的三大组件:深度神经网络、海量图像数据集与图形处理单元(GPU)。深度神经网络构成了 AlexNet 的核心架构,其拥有多个层,能够学习极其复杂的视觉特征。该网络以 Krizhevsky 的名字命名,纪念他实现了这套系统并完成了广泛的训练过程。

与传统 AI 系统不同,之前的 AI 项目要求程序员手动指定要在图像中寻找哪些特征。相比之下,深度网络则能够自动发现不同抽象级别的模式——从早期图层的简单边缘与纹理,到更深层中的复杂对象部分。

但需要注意的是,AlexNet 使用专门用于处理图像等网格状数据的 CNN 架构,这与当今大语言模型(例如 ChatGPT 和 Claude)依托的 Transformer 模型有所区别。后者源自谷歌研究院 2017 年的一项发明,Transformer 擅长处理顺序数据并通过所谓“注意力”机制捕捉文本及其他媒体中的长距离依赖关系。

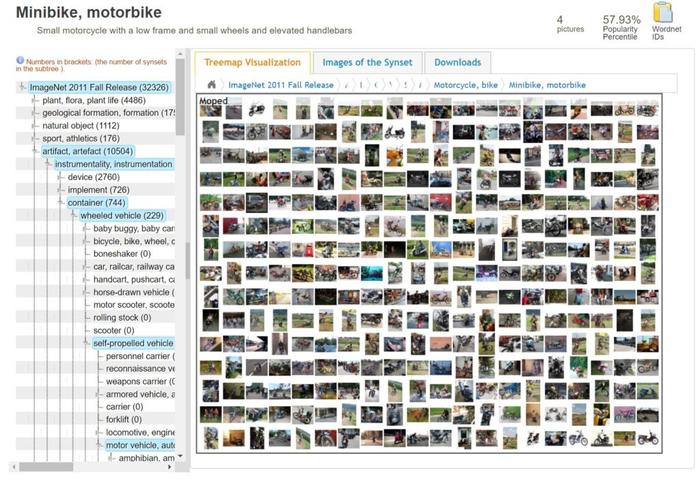

在训练数据方面,AlexNet 使用了 ImageNet,即斯坦福大学教授李飞飞博士于 2006 年建立的数据库。李飞飞收集了数百万张互联网图像,并将其整理成名为 WordNet 的数据库当中。亚马逊 Mechanical Turk 平台项目的工作人员则帮助对这些图像进行了标注。

2020 年拍摄的 ImageNet 数据库截图

2020 年拍摄的 ImageNet 数据库截图该项目需要强大的算力资源才能处理这些数据。为此,Krizhevsky 在父母家卧室的一台计算机上安装了两张英伟达显卡,并借此完成了训练过程。神经网络会并行执行大量矩阵计算,而图形芯片能够很好地处理这些任务。在黄仁勋的领导下,英伟达于 2007 年发布的 CUDA 软件为其图形芯片赋予了可编程能力,由此掀开了显卡在非图形任务领域的一路狂飙。

ImageNet 和 NVIDIA 的 CUDA 最初都只是相对小众的技术成果,正等待合适的环境来展现其真正价值。2012 年,AlexNet 首次将这些元素(深度神经网络、大数据集和 GPU 计算)结合在一起,并取得了开创性的成果。

Krizhevsky、Sutskever 和 Hinton 的论文于 2012 年秋季发表,并由 Krizhevsky 在 10 月意大利佛罗伦萨的一场计算机视觉会议上公开展示。经验丰富的计算机视觉研究者对此持怀疑态度,但出席会议的 Yann LeCun 将其称为 AI 领域的转折点。他的判断是正确的。在 AlexNet 之前,几乎没有顶级计算机视觉论文使用神经网络,而在它之后,几乎所有的论文都开始采用神经网络。

2012 年发表的开创性论文已被引用超过 172,000 次

2012 年发表的开创性论文已被引用超过 172,000 次AlexNet 的影响当然不仅限于计算机视觉。如今,深度学习神经网络正在为语音合成、游戏系统、语言模型和图像生成器等提供支持。而从负面角度来看,它们也在生成大量社交垃圾信息、帮助集权者监控民众甚至篡改历史记录,最终有可能造成严重的社会撕裂。

核心开发者们如今在做什么?

在取得突破的 13 年之后,AlexNet 的核心开发者们将自己的专业知识运用到了不同方向,每个人都在以独特的方式继续为 AI 领域做出贡献。

在 AlexNet 取得成功之后,Krizhevsky、Sutskever 与 Hinton 成立了名为 DNNresearch 的公司,并于 2013 年被谷歌收购。自此之后,各位团队成员走上了不同的发展道路。Sutskever 于 2015 年参与创立了 OpenAI,该公司于 2022 年发布了 ChatGPT,近期又推出了 Safe Superintelligence (SSI) 并以初创身份获得 10 亿美元融资。Krizhevsky 则于 2017 年离开谷歌,在 Dessa 从事新的深度学习技术研究。

Hinton 因警告未来 AI 系统的潜在危险而备受争议,他于 2023 年从谷歌辞职,以便能更自由地讨论这个话题。去年,Hinton 与 John J. Hopfield 共同获得了 2024 年诺贝尔物理学奖,以表彰他们在上世纪 80 年代初在机器学习领域做出的开创性贡献。消息一出,整个科学界备受震动。

关于成就 AlexNet 的最大功劳该归于谁,Hinton 以他特有的幽默感向计算机历史博物馆做出了这样的介绍:“Ilya 觉得我们应该试试,Alex 把事做成了,却是我得了诺贝尔奖。”

财经自媒体联盟

4000520066 欢迎批评指正

All Rights Reserved 新浪公司 版权所有

第一财经日报

第一财经日报  每日经济新闻

每日经济新闻  贝壳财经视频

贝壳财经视频  尺度商业

尺度商业  财联社APP

财联社APP  量子位

量子位  财经网

财经网  华商韬略

华商韬略